Implementasi Metode Optimasi Gradient Centralization untuk Pembuatan Model Klasifikasi Citra Pemandangan Alam

on

JNATIA Volume 1, Nomor 1, November 2022

Jurnal Nasional Teknologi Informasi dan Aplikasinya

Implementasi Metode Optimasi Gradient Centralization untuk Pembuatan Model Klasifikasi Citra Pemandangan Alam

Pasha Renaisan1, I Gede Santi Astawa2

Program Studi Informatika, Fakultas MIPA, Universitas Udayana Jl. Kampus Bukit Jimbaran, Badung, Bali 1pasha.renaisan@gmail.com 2santi.astawa@unud.ac.id

Abstract

Optimization algorithms are algorithms that are needed to properly train Neural Networks. Optimization algorithms help improve model performance by modifying the attributes of the neural network, such as weights and learning rate to further enchant the model. Gradient Centralization is a new optimization algorithm that optimizes by centralizing gradient vectors to have zero mean. This paper focuses on finding the optimal learning rate for Gradient Centralization and uses that learning rate to create a classification model to classify natural scene images. The optimal learning rate obtained by this research is 2e-5 and the model obtained 84,17% mean recall, 84,39% mean precision, and overall 83,60% accuracy.

Keywords: Classification, Natural Scene Images, Gradient Centralization, Learning Rate, Confusion Matrix

Metode optimasi adalah aspek yang sangat penting untuk melatih Deep Neural Network (DNN) dengan efisien dan efektif [1]. Salah satu metode optimasi yang cukup baru adalah metode optimasi Gradient Centralization. Gradient Centralization adalah salah satu metode optimasi model yang bekerja dengan mensentralisasi vektor gradien yang didapat dari proses backpropagation agar memiliki nilai rata-rata 0 [1]. Metode ini pertama kali dicetuskan oleh Hongwei Yong, Jianqiang Huang, Xiansheng Hua, dan Lei Zhang pada papernya yang berjudul Gradient Centralization: A New Optimization Technique for Deep Neural Networks di tahun 2020.

Metode optimasi juga merupakan aspek yang sangat penting dalam penggunaan metode Convolutional Neural Network (CNN) untuk menganalisis data citra karena konsep CNN sangat mirip dengan konsep DNN. Konsep CNN mirip dengan DNN, namun CNN diutamakan untuk menganalisis data citra, dimana CNN memungkinkan untuk mendapatkan fitur-fitur dari data citra dan memasukkannya ke dalam arsitektur model [2]. Performa dari CNN dipengaruhi oleh beberapa parameter seperti ukuran dataset, jumlah kelas, weight, hyperparameter, dan juga metode optimasi [3]. Karena performa dari CNN dipengaruhi juga oleh metode optimasi, maka metode optimasi baru Gradient Centralization dapat diimplementasikan juga pada arsitektur model CNN.

Salah satu kasus klasifikasi gambar yang bisa diselesaikan dengan pembuatan model CNN adalah klasifikasi gambar pemandangan alam. Menurut Ondieki, aplikasi pendeteksi latar akan menjadi alat yang sangat penting bagi para digital marketers seperti instagram, karena mereka bisa menggunakanya untuk meningkatkan performa mereka dengan mendapatkan informasi tempat konsumen mereka mengunggah foto dan menggunakan informasi tersebut untuk membantu pengiklan menargetkan konsumen mereka [4]. Dari pernyataan ini, maka model untuk klasifikasi citra pemandangan alam bisa membantu para pemasar digital, karena pemandangan alam adalah salah satu bagian dari latar yang sering digunakan seseorang sebagai latar foto dan diunggah ke media sosial.

Penelitian ini akan melakukan pembuatan model untuk mengklasifikasikan gambar pemandangan alam. Model akan dibuat dengan melakukan transfer learning dari model Visual Geometry Group (VGG-16) dan menggunakan metode optimasi Gradient Centralization. Penelitian ini juga akan melakukan parameter tuning untuk mendapatkan learning rate terbaik yang akan digunakan pada metode optimasi Gradient Centralization untuk pembuatan model. Adapun dataset yang digunakan untuk pembuatan model ini adalah Intel Image Dataset yang berisikan sekitar 17 ribu data pemandangan alam dengan 6 label berbeda.

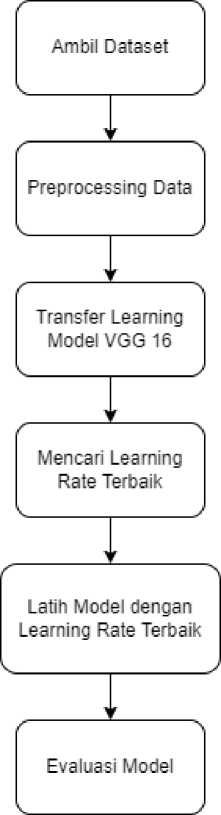

Penelitian akan dilakukan dengan membuat model klasifikasi untuk mengklasifikasikan dataset pemandangan alam ke 6 label berbeda dengan menggunakan metode transfer learning dan menggunakan metode optimasi Gradient Centralization. Adapun tahap dari berjalanya penelitian ini ditunjukkan pada Figure 1.

Figure 1. Diagram Alur Penelitian

Data yang digunakan pada penelitian ini adalah data Intel Image Dataset yang diunggah di web “https://datahack.analyticsvidhya.com/” oleh Intel sebagai dataset kompetisi klasifikasi gambar. Data ini terdiri dar 14 ribu data latih, 3 ribu data uji, dan 7 ribu data untuk prediksi. Penelitian hanya menggunakan data latih dan data uji saja dikarenakan data prediksi tidak diberi label. Dataset ini memiliki 6 label, yaitu buildings, forest, glacier, mountain, sea, dan street. Contoh data pada setiap label ditunjukan pada Table 1.

Table 1. Contoh data pada setiap label dataset

|

No |

Data |

Label |

|

1 |

L.⅛Sθ l?!Jm |

Buildings |

|

2 |

Il 'i |

Forest |

|

3 |

t ®r , ^^'c∙-'-wλ. - ∏ ^ |

Glacier |

|

4 |

Mountain | |

|

5 |

Sea | |

|

6 |

■VIL 1 ,* =∙"Λ^i HH∏^liit^ljB |

Street |

Preprocessing data dilakukan sebelum membuat model klasifikasi. Preprocessing data dilakukan untuk mempersiapkan data sebelum digunakan untuk proses pelatihan model. Adapun tahapan preprocessing data yang dilakukan pada penelitian ini adalah sebagai berikut:

-

a. Normalisasi Data

Normalisasi data adalah mengatur ulang nilai pixel gambar yang awalnya berada pada rentangan 0-255 menjadi rentangan 0-1. Normalisasi data latih dan data uji pada penelitian ini dilakukan dengan membagi nilai pixel data gambar dengan 255.

-

b. Mengubah Ukuran Data

Data pada penelitian ini akan diubah menjadi ukuran (224, 224, 3) dari ukuran (150, 150, 3) karena model VGG-16 awalnya dilatih menggunakan data dengan ukuran tersebut.

-

2.3. Transfer Learning Model VGG-16

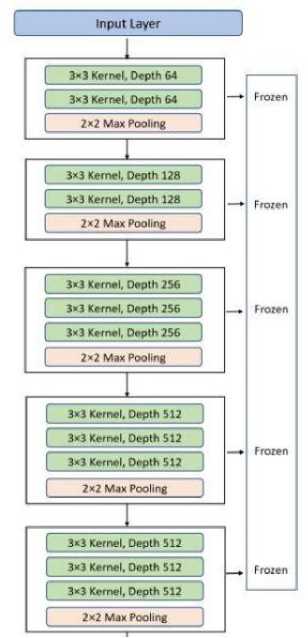

Model pada penelitian ini dibuat dengan menggunakan metode transfer learning dari model VGG-16. Langkah yang dilakukan adalah sebagai berikut:

-

1. Membekukan layer pada arsitektur model VGG-16 agar layer-layer tersebut tidak ikut dilatih sehingga mempercepat komputasi. Adapun layer yang dibekukan dari arsitektur model VGG-16 ditunjukkan pada Figure 2.

Figure 2. Layer VGG-16

-

2. Melakukan fine tuning model, dimana akan dibuatkan satu set fully-connected-layer baru untuk mengganti fully-connected-layer pada VGG-16, pada satu set layer inilah pelatihan akan dilakukan.

Mencari learning rate dilakukan dengan melatih model hasil transfer learning dengan iterasi sedikit dan dengan rentang learning rate tertentu. Nantinya dari hasil pelatihan ini akan diambil learning rate yang menghasilkan akurasi terbaik untuk dilakukan pelatihan model lebih lanjut.

Pelatihan model dilakukan setelah learning rate terbaik didapatkan. Pelatihan dilakukan menggunakan learning rate terbaik tersebut dengan iterasi lebih banyak. Metode optimasi yang digunakan pada penelitian ini adalah Gradient Centralization. Adapun persamaan dari metode optimasi Gradient Centralization adalah sebagai berikut:

GC(Vwi L') = Vwi L - μVwiL (1)

Keterangan: w = weights

L = fungsi loss

Vwi L = gradien

μ VwiL = rata-rata gradien

Evaluasi model dilakukan untuk menganalisis performa dari model yang sudah selesai dibuat. Evaluasi pada penelitian ini dilakukan dengan memasukkan data uji ke dalam model lalu akan dihitung akurasi, presisi, dan recall dari model.

Pada pembuatan model klasifikasi didapatkan beberapa hasil yang dijabarkan sebagai berikut:

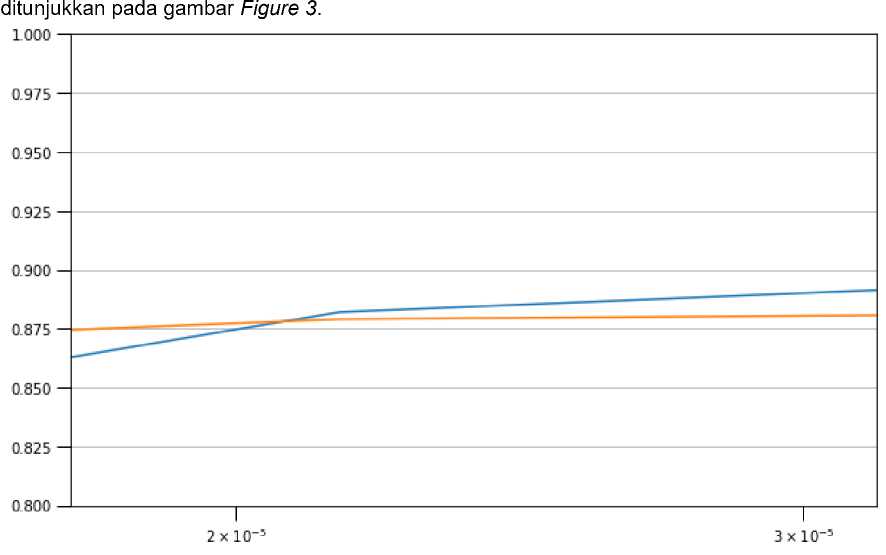

Pada proses pencarian learning rate, learning rate terbaik terdapat pada kisaran 2e-5 hingga 3e-5. Sehingga pelatihan model lebih lanjut pada penelitian ini dilakukan dengan menggunakan learning rate 2e-5. Kisaran akurasi pelatihan data dengan learning rate 2e-5 hingga 3e-5

Figure 3. Grafik Akurasi Pencarian Learning Rate

Dapat dilihat pada grafik bahwa validasi akurasi dari pelatihan (garis kuning) pada kisaran learning rate tersebut cenderung tinggi dan konsisten sehingga dapat disimpulkan bahwa learning rate pada kisaran tersebut optimal.

Pembuatan model klasifikasi dilakukan dengan menggunakan parameter learning rate 2e-5 pada metode optimasi Gradient Centralization. Pada proses evaluasi model dengan data uji, didapatkan confusion matrix yang ditunjukkan pada Figure 3.

Confusion Matrix

|

400 |

0 |

0 |

O |

2 |

35 |

|

- 4 |

451 |

1 |

2 |

O |

16 |

|

- 9 |

4 |

434 |

46 |

55 |

5 |

|

- 21 |

4 |

IlO |

276 |

105 |

9 |

|

- 7 |

3 |

3 |

O |

493 |

4 |

|

- 42 |

0 |

O |

O |

5 |

454 |

|

buildings |

forest |

glacier |

mountain |

sea |

street |

|

Drorlirtari WaIi ιαc | |||||

Figure 4. Confusion Matrix

- IOO

- O

Berdasarkan confusion matrix yang didapatkan, maka didapatkan presisi dan recall yang ditunjukkan pada Table2.

Table2. Tabel Hasil Evaluasi Model

|

Kelas |

Recall |

Presisi |

|

Buildings |

91,53% |

82,81% |

|

Forest |

95,14% |

97,62% |

|

Glacier |

78,48% |

79,20% |

|

Mountain |

52,57% |

85,18% |

|

Sea |

96,67% |

74,70% |

|

Street |

90,62% |

86,81% |

Adapun akurasi yang didapatkan dari proses evaluasi model adalah sebesar 83,60%, dimana dari 3000 data uji, model berhasil memprediksi 2508 data dengan benar.

Berdasarkan hasil penelitian pembuatan model klasifikasi citra pemandangan alam dengan menggunakan metode optimasi gradient centralization, didapatkan learning rate optimal yang digunakan pada metode optimasi adalah di kisaran 2e-5. Didapatkan juga rata-rata recall model yang dilatih dengan learning rate 2e-5 adalah 84,17%, rata-rata presisi dari model adalah 84,39% dan akurasi keseluruhan dari model adalah 83,60%.

References

-

[1] Yong, H., Huang, J., Hua, X., & Zhang, L. (2020). Gradient Centralization: A New Optimization

Technique for Deep Neural Networks.

-

[2] O'Shea, Keiron., & Nash, Ryan. (2015). An Introduction to Convolutional Neural Networks.

-

[3] R. Poojary and A. Pai, "Comparative Study of Model Optimization Techniques in Fine-Tuned CNN

Models," 2019 International Conference on Electrical and Computing Technologies and Applications (ICECTA), 2019, pp. 1-4, doi: 10.1109/ICECTA48151.2019.8959681.

-

[4] Ondieki, B. (2015). Convolutional Neural Networks for Scene Recognition.

Halaman ini sengaja dibiarkan kosong

396

Discussion and feedback