DEKOMPOSISI NILAI SINGULAR PADA SISTEM PENGENALAN WAJAH

on

Jurnal Matematika Vol. 2 No. 1, Juni 2012. ISSN : 1693-1394

DEKOMPOSISI NILAI SINGULAR PADA SISTEM PENGENALAN WAJAH

Beni Utomo

Laboratorium Matematika Komputasi, Jurusan Informatika, Sekolah Tinggi Teknologi Bontang e-mail: unlinearid@yahoo.o.uk

Abstract: Dekomposisi Nilai Singular atau Singular Value Decomposition (SVD) merupakan salah satu cara untuk menyatakan Principal Component Analysis (PCA). PCA sendiri merupakan suatu proses untuk menemukan kontributor-kontributor penting dari suatu data berdasarkan besaran statistika deviasi standart dan variansi. SVD merupakan proses untuk mendapatkan matriks diagonal yang elemen tak nolnya merupakan nilai singular yang akarnya merupakan eigenvalue.

SVD atas matriks kovarian C berbentuk C = U ∑ V T dengan matriks U dan V memuat eigenvektor yang sudah terurut dari nilai variansi terbesar ke nilai variansi terkecilnya. Variansi terbesar memiliki arti eigenvektor menangkap ciri-ciri yang paling banyak berubah. Sifat inilah yang dipakai untuk membentuk eigenface.

Keywords: Eigenvalue, Eigenvektor, Eigenface, SVD, PCA

-

1. Pendahuluan

-

1.1. Latar Belakang

-

Sebarang citra digital dalam hal ini citra abu-abu (greyscale) bisa dipandang sebagai suatu matriks. Ukuran citra yang menggunakan pixel sesuai dengan ukuran pada matriks yaitu baris dan kolom, sehingga citra digital adalah matriks. Selanjutnya dengan memanfaatkan sifat-sifat matriks, citra akan dikelola dengan lebih mengedepankan kajian matematis. Ka jian yang dimaksud adalah sifat-sifat matriks terutama masalah eigenvalue dan eigenvektor yang diterapkan pada matriks citra digital.

Secara umum ukuran matriks yang diperoleh dari citra berukuran sangat besar. Hal ini memunculkan masalah mengenai pengelolaan data berukuran besar yang menyebabkan perhitungan yang tidak efisien terutama masalah waktu. Karena pengelolaan data yang jumlahnya cukup besara maka dalam prosesnya nanti juga akan menggunakan kajian statistika yang diterapkan pada matriks.

-

1.2. Rumusan Masalah

Penelitian ini akan lebih menekankan penggunaan matematika pada teknologi, dalam hal ini adalah teknologi pengenalan wa jah serta memberikan makna pada pengertian nilai singular, eigenvalue, dan eigenvektor pada penggunaan SVD untuk pengenalan wajah yang diperkenalkan oleh Turk dan Penland pada tahun 1991.

Secara komputasi digunakan MATLAB untuk melakukan proses pengenalan wajah. MATLAB dipilih karena dasar dari penelitian ini adalah matriks.

-

2. Tinjauan Pustaka

-

2.1. Eigenvalue dan Eigenvector

-

Permasalahan matrik eigenvalue terkait dengan persamaan vektor yang berbentuk Ax¯ = λx¯ dengan A adalah matrik bujur sangkar, x¯ adalah variabel vektor, dan λ adalah skalar. Tujuannya adalah menyelesaikan Ax¯ = λx¯. Untuk vektor x¯ = 0 yang merupakan penyelesaian trivial dari persamaan diatas tapi tentunya kurang menarik dan akan dicari penyelesaian nontrivial yaitu untuk x = 9. Penyelesaian tersebut disebut eigenvektor dari A. Penyelesaian x = 9 ada untuk suatu λ tertentu sehingga λ disebut eigenvalue dari A. Himpunan eigenvalue disebut spektrum dari A dan nilai mutlak terbesar dari eigenvalue disebut jari-jari spektral A. Hinpunan semua eigenvektor yang berkaitan dengan eigenvalue λ dari A termasuk 0 membentuk suatu ruang vektor yang disebut eigenspace atau ruang eigen.

-

2.2. Menentukan Eigenvalue dan Eigenvector

Menentukan eigenvalue dan eigenvector dilakukan dengan menyelesaikan persamaan matriks (A — λI) x = 0 yaitu dengan menyelesaikan persamaan linear homogen dari (A — λI)x = 0. Persamaan tersebut akan mempunyai penyelesaian nontrivial jika dan hanya jika determinan koefisien matrik (A — λI) yaitu:

|

a ii — λ a 12 • • • a i n | |

|

D (λ) = det (A — λI) = |

a 21 a 22 — λ • • • a 2 n • • • • • • • • • • • • an 1 an 2 • • • anm — λ |

D(λ) disebut determinan karakteristik. Dengan mengembangkan D(λ) akan ditemukan polinomial b erdera jat dalam n dan λ disebut polinomial kharakteristik A.

Teorema 2.1 Eigenvalue

Eigenvalue dari matriks bujur sangkar A adalah akar kharakteristik dari persamaan D(λ) = 0 dari A.

Suatu matriks berukuran n × n mempunyai setidaknya satu eigenvalue serta paling banyak n eigenvalue berbeda.

Teorema 2.2

Jika x¯ adalah eigenvector dari matriks A yang berkaitan dengan eigenvalue λ, maka demikian juga kx untuk k = 0.

Eigenvalue dan eigenvektor mempunyai pengaruh pada suatu matriks, pengaruh yang dimaksud adalah kekhasan dari suatu matriks. Eigenvektor merupakan arah dari sumbu suatu elipsoida (fitted el lipsoid), sedangkan eigenvalue menunjukkan signifikasi sumbu yang bersesuaian.

Gambar 1. Eigenvalue dan Eigenvector

Pada gambar tersebut titik-titik merupakan eigenvalue sedangkan kurva elipsoida merupakan kurva ellips yang didalamnya adalah eigenface dengan sumbu ellipsoida merupakan arah dari eigenvektor. Pada data yang berdimensi tinggi dalam hal ini adalah matriks yang berukuran besar maka hanya beberapa eigenvalue saja yang signifikan.

-

2.3. Singular Value Decomposition (SVD)

Diberikan matriks A berukuran m × n dengan m ≥ n . Maka salah satu bentuk dekomposisi nilai singular matriks A adalah:

A = Uh ∑ VT

dengan Uh dan VaT orthonormal dan matriks diagonal. Indeks a dan h menyatakan matriks dengan vektor-vektor aligner dan hanger yaitu UhT Uh = Im, VaVaT = In, dengan Uh berukuran m × m, Va berukuran n × n, dan

|

σ1 |

0 •• |

•0 |

0 |

|

0 . |

σ2 • • .. |

•0 . |

0 . |

|

. . 0 |

. . 0 •• |

. .. • σr-1 |

. . 0 |

|

0 |

0 •• |

•0 |

σr |

merupakan matriks diagonal berukuran m×n (dengan dimensi sama dengan A). Sebagai tambahan σ 1 ≥ σ2 ≥ ∙ ∙ ∙ ≥ σn ≥ 0 dengan σi adalah nilai-nilai singular (atau stretchers) dari A dan σi jumlah yang tidak nol sama dengan rank dari A. Rasio — jika σn = 0 bisa dipandang sebagai condition number matriks. Selanjutnya bisa dilakukan verifikasi bahwa dekomposisi nilai singular bisa juga dituliskan sebagai:

n

A = Uh∑ VT = ∑σi ∙ hi • aT

i=1

Matriks hi • aT merupakan hasil kali luar (outer product) dari baris ke-i matriks Uh yang berkorespondensi dengan baris Va.

Teorema 2.3 Teorema Fundamental SVD

Untuk sebarang matriks berukuran m × n dengan m ≥ n, A : Rn → Rm terdapat suatu basis orthonormal {a 1, a2, ∙ ∙ ∙ , an} atas Rn, yang diperoleh dari Teorema Spektral, sebagai eigenvektor dari AT A. Definisikan:

-

i. σi Il Aai Il, untuk i = 1, 2, 3, ••• ,r merupakan nilai singular tidak nol, dengan || || adalah norma Euclides dan

-

ii. hi = σiAai, untuk i = 1, 2, 3, • • • ,r dengan r ≤ n

Teorema Spektral menyatakan bahwa jika A merupakan matriks simetri dan persegi (A = AT ) maka terdapat suatu basis orthonormal dari ruang kolom R(A) yang memuat eigenvektor satuan dari A.

-

3. Metode Penelitian

Penelitian dilakukan dengan studi literatur dengan dasar utamanya adalah pengenalan wajah yang diberikan oleh Turk dan Penland yang dikenal dengan nama eigenface. Eigenface bekerja dengan menggunakan Principal Component Analysis (PCA). PCA merupakan suatu metoda untuk mengidentifikasi pola pada data dan menyatakan data sedemikian sehingga data tersebut tampak perbedaan dan persamaannya (difference and similarity).

-

3.1. Eigenface dan Komputasi Eigenface

Diberikan Γ yaitu suatu vektor atau data berdimensi satu berukuran N2 × 1 yang berkorespondensi dengan citra wajah berukuran N × N. Idenya adalah menyatakan Γ ( Φ = Γ — mean face) menjadi suatu ruang berdimensi rendah berikut:

Φ — mean = w 1 u 1 + w2u2 + • • • + WkUk dengan K << N

Berikut adalah langkah-langkah yang diperlukan dalam menghitung eigenface secara komputasi.

Langkah 1.

Bentuk training sets : 11,12, ∙∙∙ ,Im yaitu himpunan citra wajah (sangat penting bahwa citra wa jah harus pada posisi terpusat dan ukurannya harus sama).

Langkah 2.

Nyatakan setiap citra wajah I1 sebagai vektor Γi

Gambar 2 Representasi Citra Sebagai Vektor

Setiap kotak dari citra tersebut merupakan satu elemen matriks atau pixel. Membentuk Γi bisa dilakukan dengan proses tersebut dan dilanjutkan dengan operasi transpose matriks. Intinya adalah mengubah matriks menjadi vektor kolom.

Langkah 3.

Hitung rata-rata vektor citra wajah Ψ:

1M dengan Ψ = M Γi

i=1

Langkah 4.

Kurangkan citra wajah Γi dengan rata-rata Ψ atau Φ = Γi — Ψ

Langkah 5.

Hitung matriks kovariansi C dengan:

M

C = M ∑ΦnΦT = AAT (N2 × N2 matriks)

n=1

dengan A = [Φι Φ2 ∙ ∙ ∙ Φm] (matriks N2 × M)

Langkah 6.

Hitung eigenvektor ui dari matriks AAT . Matriks AAT ukurannya sangat besar sehingga membuat keadaan menjadi tidak praktis.

Langkah 6.1

Diberikan matriks ATA (matriks M × M)

Langkah 6.2

Hitung eigenvektor vi dari ATA dengan cara menyelesaikan AT Av = µivi.

Berikut ini hubungan antara usi dan Vi ATAvi = μiVi ⇒ AATAvi = μiAvi ⇒ CAvi = µiAvi atau Cui = µiui dengan ui = Avi

Demikian, AT A dan AAT mempunyai eigenvalue yang sama serta eigenvektor yang berkaitan seperti: ui = Avi . Diperhatikan bahwa:

-

1. AAT bisa paling banyak hingg N2 eigenvalue dan eigenvektor

-

2. ATA bisa paling banyak hingga M eigenvalue dan eigenvektor

-

3. Nilai M eigenvalue dari AT A (sepanjang dengan eigenvektor yang berkaitan) berkaitan dengan M eigenvalue terbesar dari AAT (sepanjang berkaitan dengan nilai eigenvektornya)

Langkah 6.3

Hitung M eigenvektor terbaik dari AAT : ui = Avi (penting: normalisasi ui sehingga INI = 1)

Langkah 7.

Jaga hanya K eigenvector (berkaitan dengan K eigenvalue terbesar).

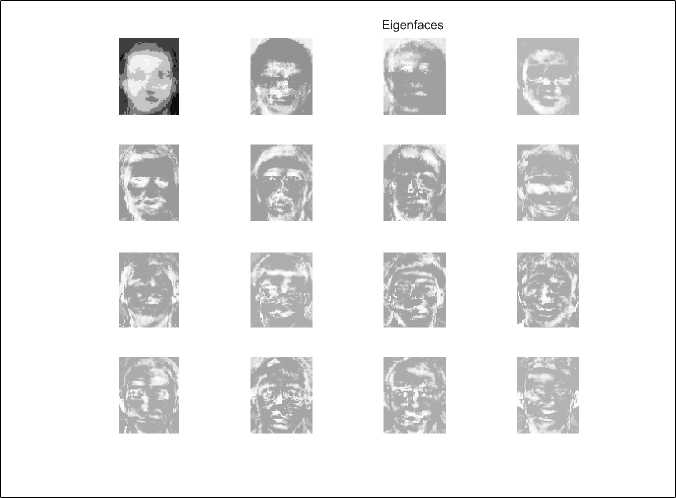

Pada proses tersebut aljabar linear dipakai untuk menentukan komponen utama distribusi dari citra wajah atau eigenvektor dari matriks kovariansi himpunan citra wa jah. Eigenvektor tersebut bisa dipikirkan sebagai suatu himpunan yang memberikan karakteristik variasi antar citra wa jah. Setiap citra wajah tersebut memberikan kontribusi baik besar atau kecil pada eigenvektor sehingga eigenvektor bisa ditampilkan sepintas menyerupai wajah berhantu (ghostly face) yang disebut sebagai eigenface.

-

4. Hasil dan Pembahasan

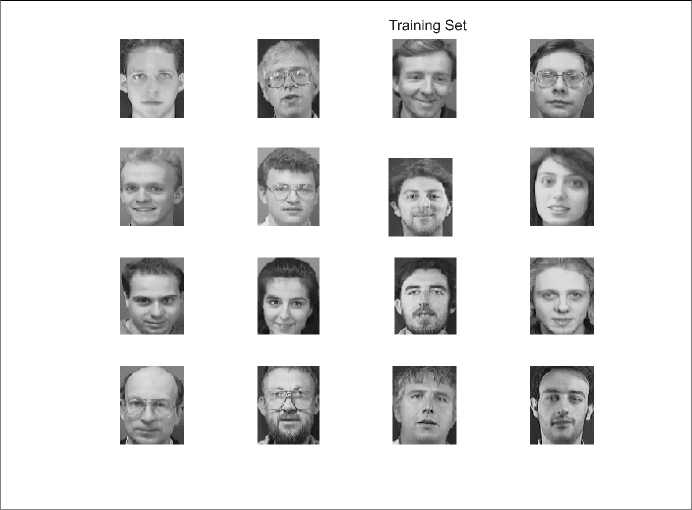

Citra yang akan dipakai untuk membentuk training set dipilih dengan syarat-syarat seperti yang telah ditetapkan sebelumnya, dan untuk penelitian ini dipilih sebanyak 16 citra wajah. Citra digital diambil dari basis data citra yang bisa diperoleh di http://www.cl.cam.ac.uk, serta source code mengenai eigenface yang ditulis oleh Serano.

Citra yang akan dipakai untuk membentuk training set dipilih dengan syarat-syarat seperti yang telah ditetapkan sebelumnya, dan untuk penelitian ini dipilih sebanyak 16 citra wajah. Citra digital diambil dari basis data citra yang bisa diperoleh di http://www.cl.cam.ac.uk, serta source code mengenai eigenface yang ditulis oleh Serano.

Langkah 1.

Suatu citra digital yang berukuran m × n pixel berkorespondensi dengan matriks yang memiliki n baris dan m kolom. Setiap citra wajah pada training set berukuran sama yaitu 112 × 92 pixel maka menghasilkan matriks I berukuran 112 × 92 akibatnya diperoleh {12,13, ∙∙∙ ,Iι6}

Gambar 3. Training Set

Dengan menggunakan Matlab maka diperoleh training set berupa himpunan matriks citra wajah tersebut.

Gambar 4. Training Set

Langkah 2.

Selanjutnya menyusun matriks kolom atau vektor Γ berdasarkan citra wajah I , yaitu dengan membentuk {Γi, i = 1, 2, • • • , 16} . Untuk setiap Ii dibentuk Γi sebagai berikut:

|

i1,1 |

Y1,1 | ||||||

|

··· |

Y 2,1 | ||||||

|

I= |

^ i 1,1 i 2,1 ··· |

i 1,2 • i 2,2 • ··· ·· |

• i 1,92 • i 2,92 · ··· |

⇒ Γ = |

i112,1 i1,2 |

Y3,1 Y4,1 | |

|

··· i112,2 ··· |

= |

Y 5,1 ··· | |||||

|

i112,1 |

i112,2 • • |

• i112,92 |

112 X 92 |

··· | |||

|

i1,92 |

Y10303,1 | ||||||

|

i112,92 |

10304X1 |

Y10304,1 |

Untuk setiap matriks kolom Γi dibentuk matriks S dengan S =Γ1 Γ2 ∙ ∙ ∙ Γ16

Hal ini dilakukan untuk meletakkan setiap citra pada matriks yang sama.

10304 X16

|

Y1,1 Y 2,1 ··· |

Y1,2 • • Y2,2 • • ··· ·· |

• Y1,16 • Y2,16 · ··· |

⇒ [Γ1 Γ2 • |

• γ16] ⇒ S |

|

Y10304,1 |

Y10304,2 • • |

• Y10304,16 |

Langkah 3.

Selanjutnya dihitung rata-rata vektor citra wajah Ψ. Proses ini bisa dilakukan dengan menjumlahkan semua citra Γ1 + Γ2 + · · · + Γ16 dan membaginya dengan jumlah total

1 16

citra yaitu: Ψ = —^Γi. Hasilnya merupakan citra rata-rata Ψ yang menghasilkan

i=1

citra wajah yang kabur.

Gambar 5. Citra Rata-rata

Langkah 4.

Proses selanjutnya adalah mengurangkan setiap citra wajah Γi dengan rata-rata Ψ atau Φi = γi — Ψ (deviasi dari rata-rata) sehingga pada langkah ini diperoleh matriks Φi untuk i = 1, 2, • • • , 16. Vektor Φi merupakan selisih antara citra dengan rata-rata citra yang berarti suatu variansi. Hal ini bisa diartikan sebagai perbedaan ciri-ciri pada wajah yang memisahkan satu citra dengan lainnya seperti hidung yang lebar, jarak antar mata yang dekat terhadap rata-rata wa jah. Proses ini menghilangkan ciri-ciri yang sama yang terdapat pada setiap citra wajah. Selanjutnya untuk setiap vektor Φi bisa membentuk matriks A dengan:

Φ1,1 Φ1,2

Φ 2,1 Φ 2,2

Φ1,16

φ 2,16

⇒ Φ1 Φ2 · · · Φ16 ⇒ A

.φ10304,1 φ10304,2 ∙ ∙ ∙ φ10304,16.

Langkah 5.

Dengan dihilangkannya ciri-ciri yang sama pada citra wajah, selanjutnya bisa digunakan matriks baru A (dengan ciri-ciri perbedaan yang besar) untuk menghitung simpangan setiap citra terhadap rata-ratanya. Inilah kovariansi matriks C . Menghitung kovariansi matriks C berarti membandingkan elemen baris pertama dengan baris kedua, baris kedua dengan baris ketiga, baris ketiga dengan baris keempat dan seterusnya. Hal ini menyatakan telah dibandingkannya elemen-elemen pada semua citra. Elemen yang terletak pada diagonal utama matriks kovariansi adalah variansi, yang merupakan struktur unique dari citra. Sedangkan elemen lainnya merupakan redundant dari himpunan citra. Matriks kovariansi C dinyatakan dengan:

1 16

C = 16 ∑ Φn Φ n = AAT dengan A = [Φ1 Φ2 ∙∙∙ Φ1β] n=1

Matriks tersebut merupakan matriks yang dibangun oleh ruang baris matriks A yang berukuran sangat besar yaitu 10304 baris dan 10304 kolom. Dengan ukuran yang demikian besar maka memerlukan waktu yang besar pula untuk menghitung dan memprosesnya.

Meskipun matriks ATA berukuran besar tetapi sebenarnya elemen matriks ATA merupakan matriks sehingga ATA bisa dipandang berukuran 20 × 20. Selanjutnya dilakukan penyederhanaan perhitungan dengan menggunakan eigenvektor dari AT A dan AAT . Nilai singular dari ATA dan AAT adalah nilai tak nol dari akar kuadrat eigenvalue. Dengan mengambil nilai tak nol dari eigenvalue, dekomposisi nilai singular bisa dikon-struksi untuk menyatakan hubungan antara AT A dan AAT . Pertama akan dihitung dekomposisi nilai singular dari AAT untuk menentukan eigenvalue dan eigenvektornya. Berikut adalah penjelasannya.

A = U∑VT

AA = U∑VTU∑VT

AAT = U∑VT(U∑VT)T

T

= U∑VT(VT)T∑UT

T

AAT = U∑VTV ∑UT (karena VTV = I)

T

AAT = U UT

2

AAT = U U T (karena matriks diagonal)

Selanjutnya eigenvektor dari AAT disebut vektor U singular kiri yang dibangun oleh ruang baris matriks A. Langkah selanjutnya adalah menghitung dekomposisi nilai singular dari matriks AAT untuk menentukan eigenvalue dan eigenvektornya. Dengan langkah yang identik diperoleh:

A = U∑VT

AA = U∑VTU∑VT

ATA = (U ∑ VT)TU ∑ VT

T

ATA = (VT)T UTU VT

T

ATA = V ∑UTU ∑V T

T

ATA = V VT

2

ATA = V ∑VT

Eigenvektor dari ATA merupakan vektor V singular kanan yang dibangun oleh ruang kolom matriks A. Hasil dari proses ini merupakan matriks berukuran 20 × 20 sehingga lebih mudah dihitung. Matriks ATA dan AAT mempunyai eigenvalue tak nol σ yang sama, sedangkan eigenvektor kedua matriks tersebut memiliki hubungan sebagai berikut:

Avi = σiui

Selanjutnya dari matriks AT A diperoleh eigenvektor yang akan menyusun eigenface. Eigenface terlihat tampak seperti area terang dan gelap yang tersusun atas pola tertentu yang diperoleh dari penghitungan ciri-ciri wajah atas suatu matriks.

Pada pembahasan sebelumnya mengenai matriks citra yang dinormalkan Φ = Γ — Ψ, selisih Φ dapat dinyatakan sebagai kombinasi linear eigenvektor ui . Setiap citra yang dinormalkan diproyeksikan ke ruang eigen untuk mendapatkan bobot

wi = uiT Φ

dengan ui menyatakan eigenface

Citra normal berbobot membentuk suatu vektor Ω yang dinayatak sebagai basis

Ωi =

w 1 w i

. . .

wKi

: dengan i = 1, 2, ∙ ∙ ∙ ,M

Dalam bahasan diatas M bernilai 16. Dengan mengikut prosedur dari metode yang digunakan diperoleh eigenface berikut ini.

Gambar 6. Eigenface

Karena setiap citra wajah merupakan vektor data maka eigenface sebenarnya merupakan eigenvektor untuk setiap eigenvalue yang bersesuaian. Selanjutnya desain tersebut

dicoba dengan menggunakan masukan menggunakan wajah asli dari orang yang citra wajahnya merupakan salah satu yang berada pada training set.

-

4.1. Pengenalan Wajah

Apa yang telah dilakukan sebelumnya merupakan langkah untuk menyusun suatu basis data yang berisikan eigenvektor-eigenvektor atau eigenface yang disebut face space atau ruang wa jah sehingga jika ada satu masukan citra wajah tertentu sistem akan menunjukkan apakah citra masukan tersebut dikenali atau merupakan wajah baru yang belum ada pada basis data. Berikut adalah prosedur pengenalan wa jah oleh sistem diatas. Misalkan dipilih salah satu dari citra wajah.

Langkah 1.

Melakukan transformasi pada wajah baru tersebutmenjadi eigenface dengan menormalkan citra matriks Γ:

Φ=Γ-Ψ

Langkah 2.

(Membandingkan citra masukan dengan cara) Memproyeksikan citra yang telah dinormalkan terhadap eigenspace sehingga diperoleh:

wn = uiT Φ (wn menyatakan bobot citra baru)

Langkah 3.

Transformasikan bobot tersebut menjadi matriks Ω dengan:

Ω = w1 w2 · · · wM

Langkah 4.

Menyatakan pengenalan citra wa jah tersebut dengan cara membandingkan citra dengan citra-citra yang ada pada ruang wajah. Proses ini dilakukan dengan cara terlebih dahulu mengambil error minimum εr = ∥Ω - Ωn ∥ dengan ε adalah metrik Euclides. Jika jarak ε lebih kecil dari batas yang ditentukan Tr maka citra masukan Γ bisa dikenali dari training set, tetapi jika ε lebih besar dari batas Tr maka citra tidak dikenali. Jika citra tidak dikenali maka citra bisa dimasukkan ke dalam basis data atau ruang wajah dengan mengulang langkah-langkah sebelumnya. Berikut ini contohnya

Citra Rekonstruksi

20 40 60 80

Gambar 7. Input dan Output

Gambar 8. Statistika Citra

-

5. Kesimpulan dan Saran

-

5.1. Kesimpulan

-

Pendekatan analisis citra menggunakan matriks dalam hal ini menggunakan MATLAB bisa mengeksplorasi sifat matriks lebih banyak yang sebenarnya adalah analisis citra digital. Sehingga pembelajaran matriks yang selalu terkait dengan susunan angka bisa lebih berkembang dengan bahasan menggunakan citra digital. Beberapa teori masih memerlukan pengembangan lebih lanjut sehingga aspek matematis dari pengolahan citra digital bisa lebih terlihat dengan menggunakan bahasa yang sederhana. Pada penelitian ini ditunjukkan arti nyata dari eigenvalue dan eigenvektor yang bisa dipandang sebagai citra digital, bukan hanya berupa susunan angka termasuk eigenface yang ternyata adalah eigenvektor yang berkaitan dengan eigenvalue terbesar.

-

5.2. Saran

Hasil yang diperoleh tersebut masih sangat sederhana dengan banyak asumsi yang dipakai sehingga memerlukan beberapa penyempurnaan diantaranya:

-

1. untuk membandingkan dua citra wajah bisa menggunakan metrik yang lain dan hasilnya bisa dibandingkan, misalkan metrik Hausdorff dan metrik Mahalanobis.

-

2. cara pengambilan citra wajah juga bisa dibuat beberapa jenis, termasuk ekspresi dan tidak perlu frontal view.

-

3. ka jian diatas baru sebatas pada citra secara umum, perlu kajian lebih lanjut misalkan anatomi atau geometri wajah termasuk posisi mata, mulut, hidung dan sebagainya sehingga harapannya bisa berhasil lebih maksimal dan diharapkan penggunaan matematika yang lebih nyata lagi.

Daftar Pustaka

-

[1] Gonzales,R.C. 2005. Digital Image Processing Using Matlab, Prentice Hall, Upper Saddle River, New Jersey.

-

[2] Kreyszig,Erwin. 1998. Advanced Engineering Mathematics, John Wiley and Sons, New York

-

[3] L.F. Chen, HY Liao, JC Lien, dan CC Han, 2000, Why Recognition in a Statistics Base-Face Recognition System Should be Based on The Pure Face Portion: a Probabilistic Decision Based Proof, Universitas Chiao Tung, Taiwan.

-

[4] Mario I. Chachon, 2009, State The Art Of Face Recognition, I Tech Education and Publishing, Vienna, Austria

-

[5] M. Turk dan A. Pentland, 1991, Eigenface for Recognition, Journal of Cognitive Neuroscience, vol. 3, No.1, pp. 71-86.

-

[6] R. Gross, Jianbo Shi, J.Cohn, 2001, Qua Vadis Face Recognition, Carnegie Mellon University, Pennsylvania

-

[7] S. Nanavati, M.Thieme, R. Nanavati, 2002, Biometrics: Identity Verification in a Networked World, John Wiley and Sons, Canada

-

[8] Soberano,L,A., 2000, The Mathematical Foundation of Image Compression, University of North Carolina at Wilmington, North Carolina.

-

[9] Wenyi Zhao, 2006, Face Processing : Advanced Modelling and Methods, Elsevier Inc http://www.cl.cam.ac.uk

Discussion and feedback